Upseo est un outil de génération de trafic artificiel, il a été conçu comme tous les autres logiciels de génération du trafic naturel. Il envoie des bots automatisés pour visiter votre site web. D’après une étude de Rapidbi, les bots ne sont jamais bons pour le référencement naturel de votre site web. Vous devez arrêter de trouver des moyens pour accélérer le SEO de votre site web. Tous les bonnes pratiques se font naturellement. Voici quelques problèmes que vous allez rencontrer lorsque vous allez utiliser un logiciel de génération du trafic naturel comme UPSEO.

Les bots peuvent nuire à votre classement SEO – Avis Upseo

Le classement SEO de votre site dépend de beaucoup de choses : qualité du contenu, backlinks fiables, temps de chargement rapide, etc. Mais les robots peuvent parcourir votre site Web et paralyser la fonctionnalité et la fiabilité de votre site Web au point où votre classement SEO plombe.

Ils peuvent surcharger et crasher votre site, ce sont des attaques DDoS, et ils peuvent rendre votre site Web complètement inaccessible. Ils se produisent lorsqu’un certain nombre d’ordinateurs infectés se regroupent pour attaquer une seule cible, épuisant vos connexions réseau et vos ressources serveur, ce qui peut causer des pannes de site Web.

1/3 des incidents de temps d’arrêt sont attribués par des attaques DDoS

Cela peut augmenter la durée de votre site, cela peut éventuellement nuire à votre classement SEO. Une courte panne n’affectera pas votre classement, mais si votre site est victime de plusieurs attaques DDoS sur une longue période de temps, votre classement pourrait être sérieusement touché. Vous voudrez vous assurer que vous sécurisez votre site Web le plus rapidement possible afin de ne pas être victime d’autres attaques.

Ils ralentiront le temps de chargement de votre site. Les scripts de bot sont de gros morceaux de données et extrêmement invasifs, donc ils ralentissent les temps de chargement de votre site. Non seulement cela frustre les utilisateurs, mais cela nuit également à votre ratio Qualité.

Les bots peuvent biaiser vos analyses – Avis Upseo

L’analyse de votre site est essentielle pour connaître le niveau de votre site, l’efficacité de votre publicité et le succès global de votre site. Les interactions des robots peuvent fausser ces analyses et vous donner de fausses données.

Les bots rempliront les formulaires de votre site – Avis Upseo

Ils rempliront les formulaires de votre site. Les formulaires du site Web peuvent vous fournir des informations sur votre clientèle et sur le trafic entrant et sortant du site Web. Mais, lorsque les robots les infiltrent, vous obtiendrez des informations incorrectes qui peuvent altérer votre base de données clients. De plus, vous aurez l’air d’avoir plus de leads que vous n’en avez en réalité.

Ils s’engagent avec vos annonces. Plus communément appelés fraude au clic, les robots trouveront vos annonces et cliqueront ensuite dessus, ce qui peut modifier vos statistiques publicitaires et falsifier votre CTR. Cela rend essentiellement vos annonces inutiles, parce que vous dépensez de l’argent sur la publicité qui n’apporte pas dans le trafic de conversion.

Il y a de fortes chances que vous ne remarquerez pas les logiciels malveillants sur votre site tant que Google ne les aura pas détectés. Vous pourriez constater une baisse du trafic car Google avertira les utilisateurs des logiciels malveillants avant de les envoyer sur votre site, ils choisiront donc probablement de faire demi-tour et d’aller ailleurs.

Les codes injectés peuvent également signifier que les robots permettent aux pirates de voler votre trafic. Vos visiteurs pourraient être redirigés vers un site qu’ils n’ont jamais eu l’intention de visiter, ce que fait le script MosQUito jQuery lorsqu’il infecte votre site WordPress ou Joomla. Un nouvel exemple de fraude publicitaire, le script MosQUito vole le trafic légitime entrant sur votre site, que ce soit à partir de la recherche ou de la publicité payante, et le dirige ensuite ailleurs.

Les bots peuvent vous piéger en cliquant. C’est ce qu’on appelle le clickjacking, et les robots l’utiliseront pour vous piéger en vous faisant croire que vous cliquez sur autre chose. Les pirates utiliseront des robots pour modifier le code de votre site et superposer une page transparente sur une page Web que vous visitez. Ainsi, pendant que vous pensez que vous cliquez pour gagner un iPad, vous cliquez sur un lien qui donne automatiquement votre argent au hacker.

La page de superposition semble tout à fait normale, mais lorsque vous cliquez sur quelque chose, comme un bouton de lecture vidéo, vous cliquez en fait sur la page de superposition. Ces clics délicats peuvent déclencher des commandes en un seul clic à partir d’Amazon, activer des transferts électroniques, « aimer » de manière trompeuse un profil Facebook ou Twitter, ou même déclencher un téléchargement de malware.

Les bots peuvent détruire votre résultat net – Avis Upseo

Le coût moyen d’une atteinte à la sécurité d’un site Web est de 300 000€ et les robots amplifient les menaces de sécurité parce qu’ils fonctionnent beaucoup plus rapidement qu’un pirate qui tente de contourner la sécurité manuellement.

Alors que la fraude au clic peut certainement épuiser votre budget publicitaire, il existe d’autres façons dont les robots peuvent également nuire à vos revenus.

Les bots peuvent entacher votre réputation – Avis Upseo

Lorsque les clients remplissent des formulaires et font des achats chez vous, ils vous confient leurs renseignements personnels et bancaires. Les robots peuvent accéder à votre site et voler ces données, laissant vos clients en danger et votre fiabilité détruite.

Ils voleront des informations personnelles. Donner des renseignements personnels à un site Web, même s’il s’agit d’un site de confiance bien connu, est une grande préoccupation pour les internautes. C’est aussi une grande préoccupation pour les propriétaires de sites Web, qui veulent s’assurer qu’ils ne risquent pas la confiance de leurs clients en utilisant à mauvais escient des informations sensibles.

Les Bots volent des informations personnelles

Les bots peuvent cependant récolter les informations que les utilisateurs mettent dans des commentaires et des formulaires, qu’ils peuvent ensuite utiliser pour une campagne de spam ou vendre à des concurrents. Certains de ces robots peuvent même écrémer les données de carte de crédit de votre site. Vous devez faire très attention en vous assurant que les robots ne peuvent pas accéder à ces informations en mettant constamment à jour la sécurité de votre site.

Ils vont spammer votre site avec des backlinks de mauvaise qualité. Pour ce faire, les bots vendent des liens de votre site à des clients, puis commentent les articles de votre blog avec les liens de mauvaise qualité de leurs clients.

Parfois, les liens sont inoffensifs, mais ils ramènent généralement vos lecteurs sur des sites Web douteux, où les escrocs vendent n’importe quoi, des fausses pilules aux logiciels malveillants. Les escrocs utiliseront même un site tampon pour que votre public ne se rende pas compte qu’il se trouve sur un site plus sinistre au début.

Ils peuvent rendre votre site blacklisté. Qu’il s’agisse de ralentir votre site, d’injecter des logiciels malveillants ou de piraterie, toutes ces activités malveillantes peuvent briser la confiance du public de votre site.

Les bots peuvent charger votre site avec tellement de déchets qu’ils finissent par décourager toute visite légitime des clients. Cela pourrait potentiellement mettre votre site sur une liste noire (blacklist) et détruire tout ce que vous avez fait pour développer un site de confiance.

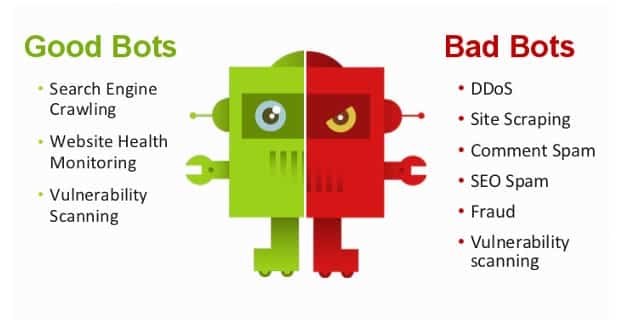

Mauvais Bots, Mauvais Bots, Mauvais Bots, qu’est-ce que tu vas faire ?

Comme vous pouvez le remarquer Upseo fait parti des mauvais bots avec le critère : « SEO Spam »

Alors, comment repérer les mauvais robots et que faire ?

Vous pouvez prendre certaines mesures préventives :

- Bloquer les utilisateurs et supprimer les commentaires de spam. Bien qu’il ne soit pas parfait, il est assez facile d’entrer et de supprimer les commentaires spammeurs sur votre blog. De cette façon, vos lecteurs courent moins de risques d’être victimes de téléchargements de logiciels malveillants.

- Obtenir un filtre de trafic pour vos annonces. Avec la filtration du trafic, vous pouvez vous assurer que vos publicités ne sont montrées qu’aux spectateurs pertinents et non aux robots.

- Bloquez l’adresse IP du bot. Bien qu’ils ne soient pas entièrement efficaces, parce que la plupart des robots utilisent de nombreuses adresses IP, une fois que vous avez identifié un robot, bloquez cette adresse IP.

- Recherchez votre site en mode utilisateur. Essayez de voir ce que vos clients voient pour vous aider à avoir une meilleure idée de leur expérience utilisateur, et de vous faire prendre conscience des robots qui se cachent derrière les invites de clics difficiles.

- Surveillez le classement de votre recherche. Si vous voyez soudainement votre rang SEO chuté, votre site pourrait être infesté de robots, et vous saurez vérifier le code de votre site et s’assurer que sa sécurité est à jour.

- Testez la vitesse de votre site. Si votre site ralentit soudainement et inexplicablement, c’est peut-être parce que des pirates utilisent des robots pour prendre le contrôle du code de votre site.

- Utilisez Copyscape. Il est rapide et facile à utiliser, et il recherchera des copies de votre site sur Internet. Ensuite, vous pouvez demander que le site supprime le contenu dupliqué afin qu’il n’affecte pas votre rang.

- Arrêtez d’utiliser des logiciels de génération de trafic naturel comme Upseo. En effet un logiciel comme Upseo va juste pourrir votre SEO sur le long terme car Google change régulièrement son algorithme pour combattre contre les logiciels malveillants et qui ne respectent pas leur charte (N’oubliez pas que Google a créé Google Ads et ne voudrait pas perdre de l’argent à cause de logiciel malveillant). Vous devez penser long terme et non court terme. SI vous utilisez Upseo et que vous avez une courbe qui descend, ne pleurez pas derrière votre écran, je vous ai prévenu. Sachez qu’avant d’écrire cet article, j’ai fait la demande à un associé de Neil Patel.

Bien qu’il n’existe aucun moyen infaillible de bloquer tous les mauvais robots en permanence, vous pouvez prendre des mesures préventives pour vous assurer que la sécurité de votre site est à jour et que l’expérience utilisateur se déroule correctement.

Comment savoir si vous êtes victime d’une arnaque par un faux générateur de trafic

Tout comme tous ceux qui se « réveillent » dans The Matrix, les utilisateurs sont confrontés à une dure réalité : 2018 a vu plus de la moitié du trafic web être des bots, et même la plus grande moitié de ce trafic était de mauvais bots. On peut supposer sans risque de se tromper qu’Internet est infecté de faux trafic, qu’il s’agisse de bots auto-régénérer de faible qualité, de bots plus sophistiqués ou de systèmes d’échange de trafic gérés par de vraies personnes et tout ce qui se trouve entre les deux. Si vous vous demandez pourquoi le faux trafic gagne tant de terrain, la réponse est simple : c’est payant.

Pour commencer, il est beaucoup trop facile pour les fraudeurs de mettre en place un faux générateur de trafic (Upseo) et de produire des données inutilisables. En tant que tel, le trafic bidon est devenu une sorte de produit de base, ce qui réduit considérablement la publicité en ligne. Deuxièmement, le trafic non humain devient de plus en plus inventif de jour en jour, passant la plupart du temps pour des lectures organiques et prouvant ainsi son efficacité.

Pendant que nous attendons les chiffres de l’année qui vient de s’écouler, voici comment vous pouvez savoir si un faux générateur de trafic comme Upseo essaie de vous arnaquer avec votre site web :

La méthode derrière les faux générateurs de trafic

Le faux générateur de trafic est n’importe quel outil (bots inclus) qui peut générer des visites sur votre page, vers n’importe quel site web et les publicités PPC des utilisateurs cibles, ce qui signifie des centaines de vues et de clics en peu de temps, ainsi que des pages et des publicités optimisées.

Ce petit logiciel fouille Internet et trouve ou utilise (selon la configuration) des proxies, puis visite automatiquement un site Web ou une annonce pour augmenter le nombre de visites. La page web en question se charge généralement en arrière-plan, de sorte que le visiteur réel ne la voit pas vraiment, il est juste enregistré comme une autre statistique.

Dans le même ordre d’idées, les échanges de trafic agissent de la même manière, mais avec une approche davantage basée sur le Web. La majorité forcera l’utilisateur à voir la page, de sorte qu’un véritable humain se trouve derrière le clic. Cependant, la personne ne fait pas partie du public cible et, à ce titre, ne s’intéresse pas vraiment au contenu.

Qu’est-ce qu’un utilisateur en retire après cette utilisation?

Rien du tout, à moins que vous ne comptiez un mal de tête et des données d’analyse gonflées comme faisant partie de la valeur de votre résultat net. Et c’est là que se trouve l’arme clé du combat. Chaque clic laisse une trace sous la forme d’une empreinte analytique, quelque chose que vous pouvez utiliser pour éviter d’être ciblé et bombardé de faux trafic.

Comment repérer les mauvais bots et ce qu’il faut faire à ce sujet

Le problème du trafic bidon est répandu et coûte à l’ensemble de l’industrie du Webmarketing des sommes importantes. Néanmoins, il existe certains moyens pour les utilisateurs de réduire leur exposition à cette maladie. Tout d’abord, les utilisateurs doivent être prudents (sans parler d’éviter d’utiliser des sites Web ou logiciels inconnus, en particulier ceux qui ont un historique relativement récent et un volume élevé de trafic et de taux de clics). Au lieu de cela, ils ne devraient travailler qu’avec des sources de trafic éprouvées qui sont transparentes sur leur trafic et qui peuvent démontrer leur capacité à détecter et à prévenir les utilisateurs suspects.

Pour des signes plus évidents de faux trafic, vous devez être minutieux avec l’analyse interne. Si vos campagnes proviennent de votre propre site Web, vous pouvez examiner le comportement des visiteurs (par exemple, le mouvement de la souris, le défilement, etc.) pour déterminer si le trafic provient d’une personne réelle et non d’un morceau de code sans intérêt se déplaçant de façon linéaire.

Vous pouvez également comparer les flux de trafic et les modèles pour détecter toute anomalie qui pourrait crier à l’arnaque. Comme pour les mesures plus spécifiques, un taux de rebond anormalement élevé peut être un signe de trafic frauduleux, de même que le nombre de pages vues et la courte durée moyenne des sessions. De plus, un pourcentage élevé de nouvelles sessions pourrait indiquer que les robots vont et viennent sans intérêt réel pour votre contenu. Il en va de même pour un grand nombre de visiteurs uniques – s’il y a peu ou pas d’engagement ou d’interaction, cela peut être un signe d’un problème sous-jacent.

Les annonces PPC sont un peu plus délicates, et beaucoup d’entre elles sont basées sur le choix mentionné ci-dessus (si tout va bien digne de confiance) pour votre source de trafic. Un coup d’œil à vos analyses exige une attention particulière à vos données liées à la géographie. Les séances doivent être cohérentes avec le contenu de votre offre. Par exemple, si une grande partie du trafic provient d’une région ou d’un pays qui parle une langue différente que vous ne ciblez pas avec votre contenu, c’est très probablement faux. De plus, si la quantité de trafic direct et de trafic de référence ne correspond pas au trafic réel, il y a de fortes chances que le trafic soit faux. Naturellement, les adresses IP, domaines et sous-domaines qui arrivent à vos publicités devraient également être sous un œil vigilant – essentiellement vos fausses règles de trafic.

Du coup, ce qu’il faut à tout prix faire à cette situation, c’est de mettre en place des stratégies vous-même et non en utilisant des outils qui vont détruire votre SEO.

Sachez aussi que Google déteste ce genre de pratique car il a mis en place Google Ads pour aider les entreprises à générer du trafic et si vous dépassez la limite ou Google et ses développeurs découvrent que vous utilisez ces pratiques, vous risquez d’avoir des punitions terribles comme un domaine backlisté.

Dernier mot

Si vous voulez à tout prix être premier sur Google et obtenir « du trafic qualifié » et non en quantité et venant de bots si vous utilisez Upseo. Vous pouvez faire appel à une agence de référencement naturel qui va vous aider à créer du contenu et optimiser le SEO de votre site pour que Google découvre la qualité de votre site et envoie en masse du trafic qualifié lié à la requête choisie par les internautes, tout cela naturellement avec des résultats tangibles sur le long terme.

7 réflexions sur “Upseo avis : Pourquoi vous ne devez pas utiliser de logiciel pour générer du trafic naturel”

Bonjour,

Je m’intéresse au soft de surveillance et d’analyse, et j’en teste actuellement.

Ayant lu un article sur UpSeo, je me penchais un peu dessus. Possibilité d’essai gratuit pendant… 1 jour :-D. Un peu léger, mais sans doute lié à ce que je n’avais pas lu ou pas compris : je pensais qu’il était comparable aux autres outils que j’ai (SEOPanel, SeeUrank, MonitoRank), mais apparemment non.

Je découvre que ce serait un truc qui ne sert à rien (trafic pour trafic, on s’en f…). Je vais gagner du temps à ne pas le tester.

Merci pour cet article.

Mon retour concernant le service d’Upseo…

Prélèvement abusif effectué sur mon compte. Effectivement le renouvellement était automatique et bien caché. Je l’ai immédiatement signalé au support moins de deux heures après le prélèvement. Demandé un remboursement. Reçu une réponse évasive. Puis redemandé un remboursement. Ignore tous mes messages depuis.

J’ai noté que d’autres utilisateurs ont rapporté la même expérience. Avec même des insultes reçues de la part du support (qui semble être le créateur lui même)

La plupart des avis positifs sur google sont des faux comptes (beaucoup de 5 étoiles avec 1 seul avis).

Vraiment des méthodes de voyous.

Fuyez.

Bonjour Théodore, oui, c’est vrai que lorsqu’on utilise un logiciel qui n’est pas légal aux yeux de Google, la question a toujours été: Qui est derrière ce logiciel. Malheureusement, quand on hack Google, on peut facilement hacker ses clients, d’où l’importance d’éviter ces méthodes illégales qui seront trouvées par Google dans les années à venir. En bref, le SEO est un travail sur le long terme, jamais sur le court terme.

Je vous remercie du feedback, je n’étais pas au courant des prélèvements automatiques abusifs.

En espérant que vous trouvez une solution rapidement.

La meilleure solution claire que j’ai à vous apporter dans ce cas-là, est de demander à votre banquier de bloquer tous les transactions avec celui-ci, cela se fait en 1 clic 😉

Un grand merci Marc pour votre dossier, très complet comme d’habitude.

Pour ma part, je suis actuellement confrontée à une baisse de positions pour le site pour lequel je travaille. Je peine à en découvrir la cause 🙁

J’espère qu’avec vos recommandations, j’arriverai à en tirer quelque chose de positif.

Avec less services de votre agence en SEO, je pourrais gagner des places et atteindre la position 1 ou 0?

A bientôt.

EN effet, cela peut être du à plusieurs critères:

Une des erreurs les plus importantes, que j’observe suite à la peur de Google Pingouin, est « l’oubli » de faire des liens internes. Ou, le fait d’utiliser la même ancre de texte, riche en mots clés. Ce n’est pas une bonne chose.

Dans l’introduction ci-dessus, j’ai lié la phrase “la mise en place du nouveau moteur de recherche Hummingbird de Google » à un article de notre blog. Ceci est un exemple de lien interne.

En faisant cela, j’aide l’article sur Google Hummingbird à se positionner sur des recherches de longue traine. La clé pour utiliser les liens internes comme effet de levier est d’éviter d’utiliser des ancres de texte riches trop souvent (ex : Chaussures de sport). Pour cette raison je n’utiliserai pas un lien d’ancre de texte riche comme « Google Hummingbird » trop souvent.

Google Pingouin prend en compte le fait que les humains ne créeront pas systématiquement la même ancre de texte, lorsqu’ils créent un lien vers une page. Ce n’est pas naturel. Pour cette raison les anciennes tactiques de Linking en utilisant des centaines, voire des milliers de fois le même ancre de texte à mots clés, non seulement ne fonctionnent plus, mais risquent de pénaliser votre site et d’entrainer son déclassement, si vous pratiquez encore ainsi.

Veillez à la qualité de votre contenu. Une des conséquences de la mise en place de Google Panda est de classer les pages de moins de 300 mots comme inintéressant pour l’internaute. Beaucoup de pages, notamment les pages de description produit de site e-commerce ainsi que des sites avec une page d’introduction au site avec peu de mots ont sérieusement perdu en positionnement sur Google.

Vous devez vous assurez d’apporter une réelle valeur à vos visiteurs avec un contenu informatif intéressant et pertinent.

N’attendez pas un résultat immédiat, lorsque vous commencez à ajouter du contenu et/ou changer des liens d’ancres de texte interne différents. Le SEO prend du temps à produire ses effets car, plus que jamais, il faut créer des liens sur le long terme et pas d’un coup sous peine d’être repéré par l’œil bienveillant du célèbre moteur de recherche.. C’est pour ça qu’il est important de bien construire son référencement naturel dès le départ en utilisant les bonnes tactiques SEO.

En espérant avoir répondu à votre problème.

Merci beaucoup pour cet article très riche. Ayant un site dans une situation similaire, j’ai vérifié ton hypothèse et c’est clairement catastrophique… 44% des pages avec 0 sessions et encore 47% avec moins de 10 sessions… En gros le trafic organique est concentré sur à peine 10% des pages.

Ce site étant un e-commerce, les pages visitées correspondent à des catégories et les produits ne génèrent presque aucune session organique… Ces pages sont utiles car elles sont visitées mais pas en page de destination.

Le contenu des pages produits a pourtant été travaillé correctement… Title optimisé, H1 optimisé et un minimum de contenu unique sur chaque produit. Cela étant dit, je ne vois pas trop quoi faire de ces produits… ils sont invisibles dans les moteurs de recherche mais utiles pour les visiteurs du site. Je ne pense pas que retravailler le contenu de ces produits changera la donne…

Je suis curieux de savoir ce qui se passerait si on passait tous ces produits en noindex… Cela ne devrait rien changer au niveau du trafic et allégerait énormément le nombre de pages indexées et donc le travail des bots. Qu’en pensez vous ?

Qu’une fiche produit génère aucune visite sur 30 jours, OK. Sur 1 an c’est déjà bien plus étonnant (embêtant). Mais autant de pages qui ne génèrent rien en 1 an, je pense tout de même qu’il doit y avoir des problèmes SEO sur le site (pas forcément tous sur les fiches produits, ça peut être le maillage ou autre chose).

Attention, passer des pages en noindex ne change rien au « travail des bots », ça ne réduit pas le crawl (sauf peut-être au bout de 6 mois quand Googlebot réalise qu’il crawle pour rien).